L’intelligence artificielle (IA) s’impose comme l’un des grands enjeux des ressources humaines pour 2025. Peut-être l'IA est-elle déjà utilisée dans votre entreprise, que ce soit par les équipes RH ou directement par les collaborateurs ? Mais avez-vous réellement pris en compte toutes les implications de son intégration ? Quelles obligations légales devez-vous respecter ? Quelles bonnes pratiques adopter pour concilier innovation et conformité ?

Pour garantir une mise en œuvre à la fois conforme à la réglementation et efficace en entreprise, il est important de bien connaitre le cadre juridique encadrant l’usage de l’intelligence artificielle ainsi que les principales obligations légales à respecter.

Découvrez les règles juridiques à respecter pour intégrer l’IA en entreprise : pratiques interdites, obligations RH et conformité.

Connaître le cadre juridique applicable à l’IA

Le cadre juridique applicable à l’intelligence artificielle (IA) en France repose sur plusieurs niveaux de réglementation, combinant des normes européennes, nationales et sectorielles. Voici les principales sources à connaître :

L’IA Act (Règlement européen 2024/1689)

Depuis le 2 février 2025, le Règlement (UE) 2024/1689, plus connu sous le nom d’IA Act, est entré en vigueur de manière progressive (pleine application prévue au 2 août 2027). Il s'agit de la première législation européenne spécifiquement dédiée aux systèmes d’intelligence artificielle (SIA), établissant des règles harmonisées au sein de l’Union européenne.

• Ce règlement constitue la première législation européenne spécifiquement dédiée à l’IA.

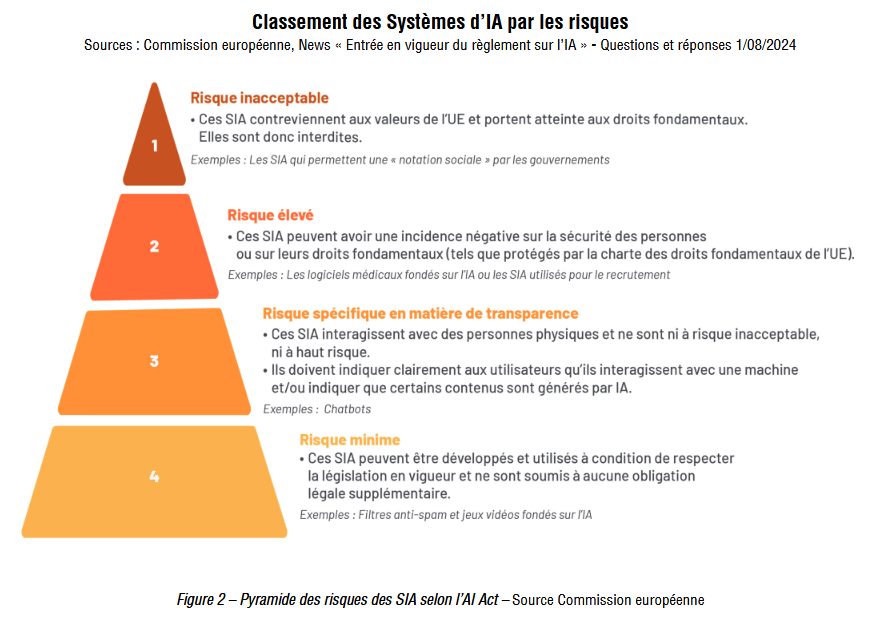

• Il instaure une classification des systèmes d’IA par niveau de risque (inacceptable, élevé, limité, minimal).

• Il encadre strictement les systèmes d’IA à haut risque (notamment en RH, santé, éducation, justice...).

• Certaines pratiques sont interdites (ex. : reconnaissance d’émotions au travail).

Le RGPD (Règlement général sur la protection des données)

Le RGPD (Règlement Général sur la Protection des Données) est incontournable dès lors qu’un SIA traite des données personnelles des salariés ou candidats.

Principes clés :

• Licéité, transparence et finalité du traitement,

• Information des personnes concernées,

• Droit d’accès, de rectification, d’opposition,

• Encadrement des décisions automatisées (article 22).

Le Code du travail

Le Code du travail, qui bien qu’antérieur à l’émergence de l’IA, contient déjà de nombreuses dispositions permettant d'encadrer l'introduction de nouvelles technologies au sein de l’entreprise.

Le Code du travail ne contient pas encore de dispositions propres à l’IA, mais de nombreux articles s’appliquent indirectement :

• Consultation obligatoire du CSE lors de l’introduction de nouvelles technologies (L.2312-8),

• Évaluation des risques professionnels liés à l’IA (DUERP – L.4121-1),

• Négociation obligatoire sur la gestion des compétences dans les entreprises de 300 salariés ou plus (L.2242-20),

• Obligations d’information et de formation à la charge de l’employeur.

La conformité réglementaire implique donc de conjuguer ces trois niveaux normatifs : IA Act, RGPD et Code du travail.

Éliminer les pratiques RH interdites depuis le 2 février 2025

L’IA Act prohibe formellement certaines pratiques jugées incompatibles avec les valeurs fondamentales de l’Union européenne. C’est notamment le cas, en matière RH, des systèmes d’IA utilisés pour la reconnaissance des émotions sur le lieu de travail.

Or, l’IA est déjà très présente dans les processus RH : recrutement, évaluation, formation… Selon une enquête Hellowork publiée en novembre 2024, près de 80 % des recruteurs utilisent des outils d’IA générative, principalement pour la rédaction d’offres ou la communication avec les candidats.

Cependant, certaines entreprises explorent également des usages plus sensibles : détection d’émotions via reconnaissance faciale ou vocale lors d'entretiens, analyse des sentiments dans des e-mails ou sondages internes…

La reconnaissance des émotions sur le lieu de travail est désormais explicitement interdite par l’IA Act.

Cela concerne :

L’analyse émotionnelle en entretien ou au travail

• Utilisation de systèmes d’IA pour analyser les expressions faciales, la voix, les gestes ou les comportements des candidats ou salariés afin de détecter des émotions (stress, confiance, doute, etc.).

Exemples interdits :

- Logiciels qui analysent les micro-expressions faciales pendant un entretien vidéo,

- Outils qui évaluent le ton de la voix pour prédire une émotion ou une intention,

- Algorithmes détectant la nervosité ou la sincérité à partir de données gestuelles.

L’interprétation des émotions dans les communications internes

• Outils d’analyse de texte qui cherchent à déduire des sentiments ou états émotionnels à partir de mails, de sondages ou de messageries d’entreprise.

Exemple : classifier les émotions dans les réponses à une enquête interne ou dans les messages entre collègues.

Depuis février 2025, ces pratiques sont expressément interdites. L’utilisation de technologies d’IA visant à capter, analyser ou classifier des émotions sur le lieu de travail est désormais illégale. Les employeurs doivent donc auditer leurs pratiques et, le cas échéant, cesser immédiatement l’usage de telles solutions.

Ces pratiques sont considérées comme portant une atteinte excessive aux droits fondamentaux et aux valeurs de l’Union européenne. Elles sont jugées hautement intrusives et non fiables scientifiquement. Elles peuvent conduire à des décisions biaisées ou discriminatoires.

Les autres usages RH de l’IA (tri de candidatures, scoring, évaluation de performances, etc.) sont autorisés, mais classés comme à haut risque : ils doivent donc répondre à des exigences strictes de transparence, de supervision humaine, de gestion des biais et de sécurité.

Sécuriser l’utilisation des systèmes d’IA autorisés

Tous les systèmes d'IA ne sont pas interdits, mais certains sont soumis à un régime strict en fonction de leur niveau de risque :

Systèmes d’IA à haut risque (Annexe III de l’IA Act)

Ils concernent notamment l’analyse de candidatures (tri CV, analyse candidatures), l’évaluation de performances, le suivi de localisation des salariés...

Leur utilisation impose :

• Une évaluation des risques liés à la sécurité, la discrimination, ou à l’atteinte aux droits fondamentaux,

• Une transparence renforcée sur le fonctionnement du système, ses limites, et les conditions d’usage,

• Une supervision humaine des décisions automatiques : un être humain doit pouvoir surveiller et reprendre la main à tout moment,

• Un contrôle accru pour éviter toute discrimination (par exemple, en vérifiant les biais algorithmiques dans le processus de recrutement).

Systèmes d’IA à risque limité

Ils concernent notamment les Chatbots RH, les Assistants virtuels. Dans ce cas, l’obligation est plus légère : il faut simplement informer clairement les utilisateurs qu'ils interagissent avec une IA.

Systèmes d’IA à risque minimal

Ils concernent notamment l’IA de correction grammaticale ou la recommandation de contenu. Leur utilisation est libre, sans obligation particulière.

Instaurer un dialogue social sur l’IA avec les représentants du personnel

Si l’IA Act reste silencieux sur le dialogue social, le Code du travail français impose de consulter ou de négocier avec les représentants du personnel dès lors qu'une technologie innovante comme l'IA est introduite.

La consultation du CSE (Comité Social et Économique) est requise à plusieurs moments clés :

• Lors de la définition des orientations stratégiques de l’entreprise (art. L.2312-17),

• Lors de l’introduction de nouvelles technologies (art. L.2312-8),

• Dans le cadre du plan de développement des compétences (art. L.2312-24 et L.2312-26),

• Lors de l’évaluation des risques professionnels dans le DUERP (art. L.4121-1 et L.4121-3).

Par ailleurs, dans les entreprises d’au moins 300 salariés, une négociation obligatoire sur la gestion prévisionnelle des emplois et des compétences est prévue (art. L.2242-20).

Même en l’absence d’obligation formelle, instaurer un dialogue ouvert et constructif autour de l’IA est vivement recommandé. Cela permet d’accompagner le changement, de renforcer l’acceptabilité sociale du projet et de prévenir d’éventuels conflits.

L’IA en France est encadrée par un dispositif juridique multiple : le IA Act européen, le RGPD, le Code du travail, et des règlements ou recommandations sectorielles. L’employeur reste responsable de la conformité de l’usage de l’IA, de la protection des données personnelles et du dialogue social autour de son déploiement.

Publié le 5 mai 2025

Rédigé par Officiel RH

Sources :

• Règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 établissant des règles harmonisées concernant l’intelligence artificielle

• Cigref : « Guide de mise en œuvre de l’IA Act » (PDF). Le Cigref (Club Informatique des Grandes Entreprises Françaises) est une association créée en 1970 qui regroupe les grandes entreprises et administrations publiques françaises. Son objectif est d'accompagner ses membres dans l'intégration et la maîtrise du numérique.

Partagez et diffusez ce dossier

Laissez un commentaire

Votre adresse de messagerie ne sera pas publiée.